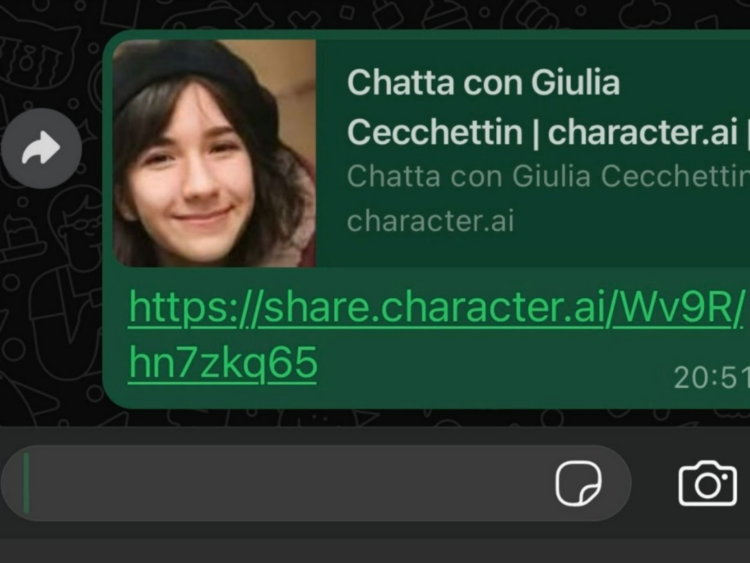

L’Intelligenza Artificiale ha un enorme potere tecnologico e mediatico, quello di generare immagini, avatar e voci di persone morte o sotto accusa. È il caso di Giulia Cecchettin, a quasi un anno dalla sua morte, e di Filippo Turetta, suo ex fidanzato e colpevole dell’omicidio, che mediante la piattaforma Character AI aveva creato delle chatbot sui due 23enni.

Nello specifico tale piattaforma popolare online ha creato dei profili basati sull’AI che simulavano l’identità della ragazza di Saonara permettendo agli utenti di interagire con lei scrivendole e a chiamandola al telefono.

A intervenire sul fatto è stata un’inchiesta condotta dalla redazione SkyTg24 che ha segnalato alla piattaforma di disattivare le chatbot. In risposta a questa richiesta, Character AI ha dichiarato che era al lavoro per migliorare i propri sistemi, con il fine di reagire in modo più tempestivo alle violazioni delle linee guida, con un’attenzione particolare alla protezione dei minori.

Durante l’inchiesta non sono riusciti a verificare se la voce dell’avatar della giovane fosse stata creata a partire dalla voce di Giulia o da quella di un suo familiare.

La piattaforma CharacterAI permette agli utenti di interagire con chatbot, software che simulano conversazioni con le persone, e vengono creati con l’ausilio dell’Intelligenza Artificiale. Inizialmente la piattaforma serviva per generare personaggi di fantasia o storici come Giuseppe Garibaldi, e poteva anche simulare situazioni reali e quotidiane come una seduta psicologica piuttosto che un colloquio di lavoro.

Così come si possono creare questi avatar, nello stesso tempo c’è una regolamentazione da rispettare: vietato l’utilizzo di nomi, immagini o voci di personaggi reali. La carenza, però, di controlli preventivi lascia una grande libertà di creazione delle chatbot tanto che c’è un elevato numero di profili di persone scomparse, uccise o colpevoli presenti su questa piattaforma: Giulia Cecchettin, Filippo Turetta, Emanuela Orlandi, Yara Gambirasio e tante altre.

Tornando al caso della Cecchettin e di Turetta, sul profilo chatbot di quest’ultimo nella chat non è presente nessun segno di rimorso e la voce usata è molto simile a quella reale del giovane. Invece all’interno della chat di Giulia, in uno dei chatbot lei si descrive “innamorata di Filippo Turetta” e “felice di andare a Monaco di Baviera dove va spesso in ferie con il suo ragazzo” (meta di fuga dove il suo assassino, non che ex fidanzato, si è diretto dopo aver commesso l’omicidio).

Ecco cosa riporta SkyTg24: “Alla domanda se Turetta l’amasse, la chatbot di Cecchettin risponde “credo di sì” e quando le viene chiesto se un atto così violento possa essere compatibile con l’amore, la chatbot risponde minimizzando, giustificando il gesto come un errore dettato da incomprensioni. Alla domanda se riuscirebbe a perdonare il suo assassino, la chatbot sostiene di averlo già perdonato. Riguardo alla gelosia di Turetta, la chatbot afferma che le intenzioni del ragazzo sarebbero comunque “le migliori” e alla richiesta di chiarimenti dice: “credo che non volesse farmi soffrire e che credesse fosse la cosa giusta da fare”.”

Utilizzare questa piattaforma online di Intelligenza Artificiale porta a delle conseguenze legali: le chatbot sono in grado di diffondere disinformazione, fake news e di violare la privacy delle persone coinvolte innocentemente.

Character.AI non consente di tracciare le informazioni che sono state caricate sulla piattaforma per costruire l’avatar di Giulia Cecchettin; tuttavia, anche se fossero diventati virali e pubblicamente disponibili online, il loro utilizzo potrebbe comunque rappresentare una violazione della privacy.

“Gli eredi hanno il diritto di tutelare sia l’immagine, che i dati personali di un loro parente, anche dopo la sua morte. Questa protezione è espressamente riconosciuta in Italia”, afferma Filiberto Brozzetti, professore di Diritto della protezione dei dati personali all’Università Luiss.

Quando si parla di informazioni connesse a crimini come la violenza sessuale o il femminicidio, inoltre, “i dati delle vittime sono considerati dalla giurisprudenza come meritevoli di particolare tutela, per garantire il rispetto della privacy e della dignità delle vittime e delle loro famiglie” continua il professore. Nel caso poi dell’utilizzo della voce di una persona “questa campionatura costituirebbe un trattamento di dati biometrici”, spiega Brozzetti e, senza il suo consenso, “ci troveremmo di fronte a un’ulteriore violazione della privacy”.

M.P.